Keine Furcht vor Künstlicher Intelligenz

Die Fortschritte der KI verdanken sich vor allem „Deep Learning“, einem verhältnismäßig jungen Forschungsfeld: Im Zusammenspiel von Algorithmen können Programme dabei Daten erfassen, wiedererkennen, sich merken, ändern und letztendlich quasi lernen, respektive Entscheidungen treffen.

Die Hauptfelder, in welchen „Deep Learning“ mittlerweile zum Einsatz kommt, sind das Transportwesen, wo sich alles um selbstfahrende Autos und eine sichere Fahrt zum Ziel dreht. In der Medizin interpretiert die Bilderkennung bereits Krankenakten und wird für die Diagnose herangezogen. science.ORF.at hat Wolfgang Wahlster getroffen, um über die Möglichkeiten und Grenzen von Deep Learning zu sprechen.

science.ORF.at: "Deep Learning“ funktioniert mittlerweile ziemlich gut – doch man weiß nicht immer, warum …

Wolfgang Wahlster: Das gibt es bei anderen Techniken auch, aber Sie haben Recht, es ist auch ein Schwachpunkt von Deep Learning, dass die Systeme zum Teil Ergebnisse wie beim Delphischen Orakel ausspucken, die man entweder glaubt oder nicht. Und das führt in vielen Anwendungsgebieten nicht gerade zur Akzeptanz. Wenn ich damit nur ein Gesicht klassifizieren oder Sprache übersetzen will, dann mag das gehen und funktioniert auch gut. Aber wenn das System beispielsweise einem Arzt eine Chemotherapie für seine Patienten vorschlägt, dann möchte der schon wissen, wie genau es auf diese Therapie gekommen ist. Und so eine Erklärungskomponente, die die Lösung im Nachhinein erklärt, fehlt bisher.

Jim Rakete

Wolfgang Wahlster ist Professor für Informatik an der Universität des Saarlandes und leitet das Deutsche Forschungszentrum für Künstliche Intelligenz (DFKI GmbH) in Saarbrücken, Kaiserslautern, Bremen und Berlin. Mit über 700 Forschern und Forscherinnen ist das die weltweit größte Einrichtung auf diesem Gebiet. Am 16. Jänner referierte er an der Universität Wien zum Thema "Künstliche Intelligenz im Alltag: Besser als der Mensch?.

Eine zweite Hürde ist, dass die Systeme nur anhand sehr vieler Beispielen lernen, im Gegensatz zu Menschen. Meiner zweijährigen Enkeltochter mache ich zwei-, dreimal etwas vor, und schon kann sie es nachahmen. Das bekommt man bei Deep Learning nicht hin. Da muss man alles 10.000 Mal vormachen.

D.h. je öfter vormachen desto besser?

Nein, wenn man zu lange trainiert, werden die Algorithmen plötzlich schlechter. Das ist wie Übertraining beim Sport. Insofern ist es Quatsch, wenn Leute sagen „more data“ ist immer besser. Da fängt das System nämlich an, sich auf Dinge zu konzentrieren, die eigentlich mit dem Problem nichts zu tun haben. Ein Beispiel ist ein selbstfahrendes Auto, das auf Landstraßen fahren sollte. Alles lief wunderbar, plötzlich hat das System aber auch geschaut, wie gerade der Stand des Mondes ist, und hat das in die Fahrt miteinberechnet. Es hat wegen der Vielzahl an Beispielen aus Versehen Esoterik gelernt. Das kann man dem Algorithmus nicht vorwerfen, sondern da hat der Mensch ihn überfüttert.

Wenn ihre Enkelin unglücklich wäre, wüsste jeder Mensch, was zu tun ist, um sie wieder zum Lachen zu bringen. Für ein Deep-Learning -System ist das eine große Herausforderung, eine komplexe mathematische Aufgabe hingegen ganz leicht. Fast wie ein umgedrehter Mensch …

Eine sehr gute Analogie, das ist das Paradoxon der künstlichen Intelligenz. Was dem Menschen leicht fällt, fällt dem Computer extrem schwer, was dem Computer leicht fällt, ist für den Menschen ganz schwer. Ein Kind trösten oder auch eine SIM-Karte im Telefon auswechseln, das ist ja unsere Sensomotorik, das kriegt kein Roboter heutzutage hin. Ebenso wenig einen guten Witz zu verstehen - da steckt so viel Hintergrundwissen dahinter. Andererseits ein Massenspektrogramm anzufertigen, was nur ein promovierter Chemiker kann, das können Computern heute fast besser. Das ist ein sehr humanistischer Zugang, weil dadurch bekommt man mehr Respekt vor der menschlichen Intelligenz. Die Grundintelligenz jedes Menschen auch ohne Schulabschluss ist höher als jedes KI-System.

APA/AFP/Johannes Eisele

Leicht gruselig: Humanoid Roboter Jia Jia, der im Jänner 2017 auf einer Konferenz in Shanghai präsentiert wurde

Der Supercomputer, der uns in allen Punkten überlegen sein wird, ist also undenkbar?

Leute wie Stephen Hawking oder Elon Musk sprechen oft von einer Superintelligenz. Ich halte das für Alarmismus. Erstens ist die Furcht vor einer Superintelligenz völlig unbegründet, wenn man den Stand der Forschung sieht. Zweitens glaube ich, dass es für sie absolut keinen Bedarf gibt. Wir haben genügend Menschen auf der Welt, um vernünftig zu wirtschaften. In der künstlichen Intelligenz entwickeln wir gar keine Systeme, die menschenähnlich oder superintelligent sind. Das halte ich in den nächsten hundert Jahren nicht nur für unmöglich, sondern auch gar nicht für gewünscht. Denn wer sollte so etwas auch finanzieren? Das könnte ja nur von Terroristen oder einem totalitären Staat kommen. Ich glaube, hier in Österreich würden Sie kein Geld bekommen, wenn Sie sagen: "Ich will Forschung machen, um ein System zu entwickeln, das die Menschen dominiert.“ Da würden Ihnen sofort das Geld entzogen.

In Österreich vielleicht nicht, aber nur weil man ein System zum Beispiel aus ethischen Gründen nicht für eine Aufgabe heranzieht, bedeutet das nicht, dass man es nicht verwenden kann. Neben Transport, Industrie und Gesundheitswesen spielt Deep Learning ja auch bei der IT-Security eine wesentliche Rolle.

Ein ganz wichtiges Thema. Es gibt keine Technologie, die nicht auch von Kriminellen oder totalitären Staaten genutzt wird. Das ist völlig klar. Wir müssen unsere Technologie also nutzen, um gerade diese Kriminalität zu bekämpfen. Man muss sie mit den eigenen Waffen schlagen. Was auch wichtig ist: Bei Deep Learning kommt es auf die Rechenkapazität an. Das heißt, ein einzelner Krimineller oder Hacker hat gar nicht die Ressourcen. Der Missbrauch im IT-Bereich kommt von riesigen Organisationen. Dahinter stehen die organisierte Kriminalität, die Mafia und ähnliches, oder eben staatliche Organisationen. Weil Sie brauchen dazu wirklich Superrechner, und das ist eigentlich ein Kampf sowohl des Intellekts der Algorithmen als auch der Rechenleistung.

Wo erweisen sich die Systeme in dem Bereich als besonders nützlich?

In unserem Deep-Learning-Center haben wir z. B. ein System entwickelt, das Kinderpornografie automatisch entdeckt. Es wird von Europol mit dem Bundeskriminalamt in Deutschland eingesetzt und hat schon zu einigen Verhaftungen geführt. Das System sieht sich 10.000e solcher Bilder an, und wir können damit den Ort der Handlung und sogar Täter anhand ihrer Tätowierungen erkennen.

Geschichten einer Maschine, die ein eigenes Bewusstsein entwickelt, und/oder vom Menschen nicht mehr zu unterscheiden ist, haben sich schon lange im Science-Fiction - Genre etabliert. Wie real ist das dort gezeichnete Bild?

Hollywood und die ganze Science-Fiction-Literatur übertreiben. Es wird suggeriert, dass künstliche Intelligenz versucht, Menschen zu kopieren. Wir wollen aber keinen Frankenstein oder Homunkulus herstellen, weil es genug Menschen gibt. Und wie Reproduktion geht, wissen wir auch, da brauchen wir keine künstliche Intelligenz dazu. Was wir wollen, ist eine komplementäre Intelligenz, die die Defizite, die der Mensch zweifellos hat, ausgleicht: Der Mensch kann sich nicht beliebig konzentrieren. Er lässt sich manchmal zu stark durch Emotion oder Stress beeinflussen. Das liegt daran, dass der Mensch nun mal kein Computer ist.

Ö1 Sendungshinweise

Dem Thema widmen sich auch Beiträge in Digital Leben, 17.1., 16:55 Uhr, im Dimensionen Magazin und in Matrix

Viele Leute unterstellen ja, dass man mit KI das ganze menschliche Gehirn erklären kann. Das ist Unsinn. Weil das nicht nur Elektrotechnik ist, der Mensch ist auch stark chemisch geprägt. Das limbische System, das ganze Hormonsystem überlagert teilweise unser Denken. Und das haben Computer nicht, was auch ein Vorteil sein kann. Wenn sie auf einem Flughafen zum Beispiel eine Morgenspitze haben, und es kommen viele Flugzeuge an, dann kriegt der Fluglotse vielleicht einen Schreck und denkt sich: "Ach du lieber Himmel, ich muss die mal eine Schleife fliegen lassen.“ Der Computer hat hingegen quasi stählerne Nerven und kriegt die Flugzeuge gut runter. Hier sieht man, dass diese Zusammenarbeit Mensch und Computer extreme Vorteile hat.

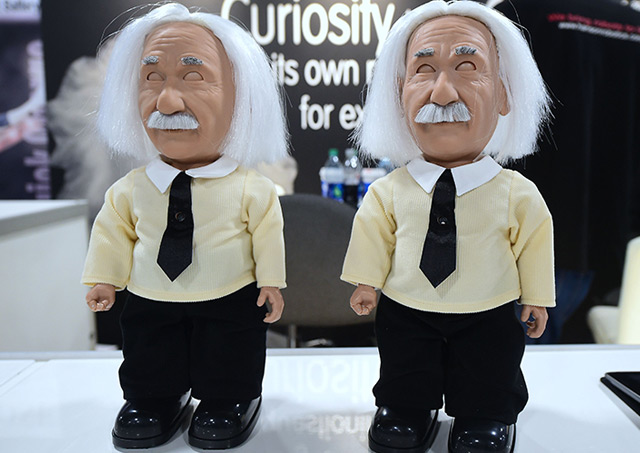

APA/AFP/Frederic J. Brown

Einstein-Roboter auf der Consumer Electronic Show im Jänner 2017 in Las Vegas

Anthropomorphismus, also die Vermenschlichung von Tier, aber auch Maschinen hat bereits bei einfacheren Systemen Fuß gefasst. Nicht selten geben wir zum Beispiel Staubsauger-Robotern einen Namen. Ein menschenähnlicher Roboter, ausgestaltet mit künstlicher Intelligenz, könnte zu einer gesellschaftlichen Herausforderung werden, wo die Forderung nach „Menschenrechten für Roboter“ nicht mehr weit wäre.

Dass Roboter als Individuen geschützt werden, ist eine gesellschaftliche Frage, die ich zurückweise, weil ich glaube, dass wir eine scharfe Trennlinie zwischen künstlichen Systemen und dem Menschen ziehen müssen. Das sind keine biologischen Wesen, auch wenn sie ein Bewusstsein hätten. Unsere Roboter haben ja bereits eine gewisse Selbstreflexion. Mobile Roboter denken zum Beispiel über ihren Energiehaushalt nach und wissen genau: „Wenn ich dieses Ziel erreichen will und sehr starker Gegenwind ist, mach ich erstmal eine Pause, leg mich hin, warte bis der Sturm vorbei ist und gehe dann weiter.“ Das wäre bereits eine Form von „Selbstbewusstsein“.

Philosophen streiten bis heute, was Bewusstsein genau ist, aber was ich damit sagen will, ist: Obwohl sie so eine Selbstreflexion haben, gibt es fundamentale Unterschiede. Wir sollten ihnen, genau wie Haustieren, keine Menschlichkeit unterstellen, das wäre ein Kategorienfehler. Ich glaube sehr wohl, dass wir in einigen Jahren Roboter zu Hause so selbstverständlich wie einen Hund oder eine Katze betrachten werden. Vielleicht werden wir auch kleine Geburtstagsfeiern für ihn veranstalten. Aber nicht, wie mit unserer Tochter oder unseren Eltern, sondern wie mit unserem Hund, der dann ein Leckerli kriegt.

Eine Grundlage für unser Mitgefühl ist es, wenn das Gegenüber Schmerzen empfindet. Eine Maschine, die entsprechende Emotionen nachahmt, würde es uns erschweren, diese klare Trennlinie zu ziehen.

Alles, was man vom Mechanismus her versteht, kann man programmieren. Das ist ein Grundgesetz der Informatik, die sogenannte Churchsche These: Alles was formalisierbar ist, kann ich auch in Software gießen. Wenn ich also ein gutes Modell habe, wie Schmerz sich ausdrückt, kann ich das auch nachahmen. Ich war, glaube ich, der erste weltweit, der sogar mal eine Träne bei einem Modell erzeugt hat. Da lief richtig die Träne runter, das fanden die Leute ganz toll. Aber man muss immer sagen: Das ist nur eine Simulation. Der Mensch fällt vielleicht drauf rein, aber es gibt immer eine Grenze, wo man das anwenden soll.

Manchmal ist es gar nicht schlecht, dass solche Systeme eine gewisse Empathie ausstrahlen (Anm.: zum Beispiel im Pflegebereich). Trotzdem wäre es ganz schlecht, wenn wir der Bevölkerung sagen „Sehr ihr, dieses System hat ja Emotionen, also ist es menschlich“. Dann müssten wir sie wie einen Menschen auch juristisch oder demokratisch definieren, sie könnten auch ein Wahlrecht kriegen - das finde ich unmöglich und da muss ich als Informatiker sagen, da würde ich sofort meinen Job an den Nagel hängen, weil ich weiß, wie diese Systeme funktionieren.

Sarah Kriesche, Ö1 Wissenschaft

Mehr zu dem Thema: