Hirnströme in Sprache übersetzt

Bereits im Jänner war es Forschern der Columbia University gelungen, die Erregungswellen des menschlichen Gehirns zu entschlüsseln und mit Hilfe eines lernfähigen Vocoders direkt in Sprache zu übersetzen. Die Leistungsfähigkeit dieser Apparatur war allerdings noch begrenzt. Das Vokabular beschränkte sich auf die Zahlen eins bis neun, auch der Klang war noch ziemlich synthetisch – und wohl nur für geübte Zuhörer verständlich.

Der Code im Gehirn

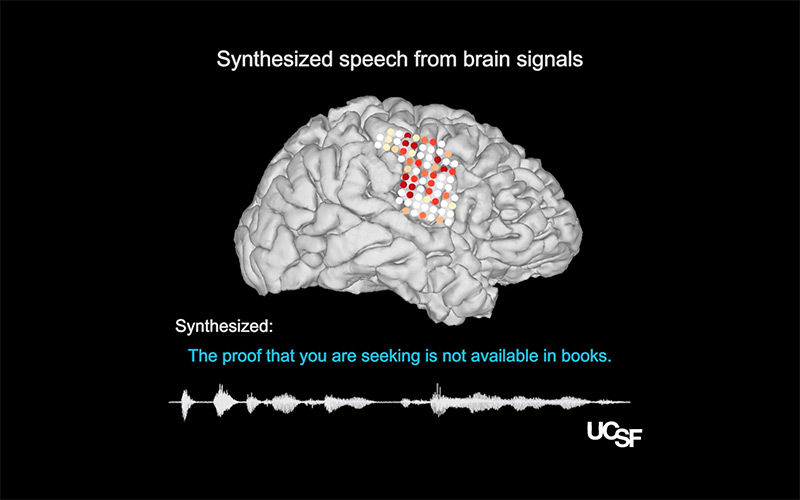

Das nun im Fachblatt „Nature“ vorgestellte Gehirn-Computer-Interface ist da bereits einen Schritt weiter. Das Gerät aus den Laboratorien der University of California in San Francisco kann in den Hirnströmen von Probanden bereits ganze Sätze erkennen und klingt deutlich organischer als das Konkurrenzprodukt aus New York. Natürlich ist auch diese Methode noch nicht perfekt, die Computerstimme klingt bei manchen Lauten noch verwaschen und scheint überhaupt über ein etwas lallendes Idiom zu verfügen, wie etwa diese Hörbeispiele in einem YouTube-Video der Forscher zeigen.

Was man freilich auch positiv deuten könnte: Wenn die Stimme lallt, dann ist sie immerhin als solche erkennbar – und dem menschlichen Vorbild offenbar näher als alle bisherigen Versuche in diesem Forschungsgebiet.

Wie Studienautor Gopala Anumanchipalli erzählt, gab es bei der Konstruktion der Gehirn-Computer-Schnittstelle vor allem eine Hürde zu überwinden: Wenn wir sprechen, werden im Gehirn zwar längst bekannte Zentren aktiv. Doch die elektrischen Signale der Neuronen sind im Grunde nichts anderes als Steuerungssignale für die Muskeln des Vokaltrakts. Sie werden also erst durch die Bewegung von Lippen, Zunge und dem Rest des Stimmapparates zum Schall, beziehungsweise zu dem, was wir unter gesprochener Sprache verstehen. Und diese Übersetzung ist keineswegs eindeutig.

Chang lab / UCSF Dept. of Neurosurgery

Das Auslesen der Hirnströme wurde an fünf Epilepsie-Patienten durchgeführt - während einer Gehirnoperation

Um dieses Problem zu lösen, konstruierten die Forscher um Anumanchipalli ein anatomisches Abbild des Vokaltrakts am Computer und koppelten diesen an ein ebenfalls künstliches neuronales Netzwerk. Letzteres lernte, welche Signale im Gehirn für die Koordination von Lippe, Zunge und Kiefer verantwortlich sind und wie sich diese fein abgestimmten Bewegungen in Kehlkopf bzw. Stimmritze zu Lauten und Wörtern zusammensetzen.

Dass der mittels Künstlicher Intelligenz gewonnene Code tatsächlich etwas über die natürlichen Verhältnisse im menschlichen Körper aussagt – also Hirnstrom in Sprachschall umwandeln kann, zeigt der Praxistest: Die maschinell erzeugten Wörter waren für Testpersonen im Internet zu 69 Prozent verständlich, bei ganzen Sätzen lag die Trefferquote bei 43 Prozent.

Ziel: Patienten eine Stimme geben

Nun feilen die Forscher an den Details. „Bei Sprachlauten wie ‚z‘ und ‚sch‘ sind wir schon ganz gut. Wir können auch das Geschlecht der Sprecher sowie die Intonation recht gut abbilden", sagt Koautor Edward Chang. Bei abrupten Lauten wie „b“ und „p“ gebe es indes noch Verbesserungsbedarf.

UCSF

Elektroden: Gopala Anumanchipalli präsentiert das von seinem Team entwickelte Interface

Letztlich soll das Interface Patienten zugutekommen, die sich aufgrund von schwerwiegenden Erkrankungen nicht mehr mitteilen können. Doch da gibt es ein Problem: So ein Decoder muss zunächst an sprechfähigen Probanden trainiert werden – was bei den genannten Patienten eben nicht möglich ist. Wie Anumanchipalli und seine Mitarbeiter in „Nature“ schreiben, böte ihr Ansatz eine mögliche Lösung: Der Decoder konnte nämlich auch die Hirnströme stimmlos nachgeahmter Sprache – wenn auch nicht ganz so präzise - übersetzen. Sollte es gelingen, die Künstliche Intelligenz nur mit den Hirnströmen allein zu füttern, also im Training selbst die Muskelbewegungen auszusparen, dann könnten auch Menschen mit Muskellähmungen wieder ihre Stimme gewinnen.

Was die Auswahl der gesprochenen Sätze angeht, hätten sich die Studienautoren auch bei den Klassikern der Weltliteratur bedienen können. Aber nichts dergleichen. Es waren ganz normale Sätze, wie zum Beispiel: „Der Schiffsbau ist ein faszinierender Vorgang.“

Mit diesem Ansatz befinden sich die amerikanischen Forscher durchaus in einer historischen Tradition. Der Praxistest neuer und wegweisender Technologien wurde eigentlich selten von Brimborium begleitet. Der erste Satz, der anno 1861 durch ein Telefon gesprochen wurde, lautete etwa: „Das Pferd frisst keinen Gurkensalat“.

Robert Czepel, science.ORF.at